サイト内に低品質なページが存在する場合、ランキングに影響を与えることがあります。低品質なウェブページとはどのようなページなのか、Googleウェブマスター向け公式ブログの記事で具体的な例が挙げられています。

http://googlewebmastercentral-ja.blogspot.jp/2012/09/more-guidance-on-building-high-quality.html

パンダアップデートは低品質なページの順位を下げるアルゴリズムです。むやみに記事を増やし、インデックス数を増やすことを目的とした場合に、サイト自体の評価が下がるということです。但し、ロボットがどういった基準で低品質であるということができるのでしょうか。項目の中には下記のような一文があります。

あなたはこの記事に書かれている情報を信頼するか?

もちろんこのようなアルゴリズムを作ることは非常に難しいです。なぜなら、信用するという人もいれば、信用しないという人もいるからです。記事の内容を見ただけでは、ロボットには判断することはできません。

以前googleの内部文書が流出しました。人間が品質をチェックするというマニュアルです。一部の人が言いました、Googleの検索エンジンは最終的に人間の目で見られているからどうしようもない。そんなはずはないと思います。日々新しいキーワードが生まれている中、一つ一つのキーワードを目でチェックして品質管理をするという方法は非常に危険です。

世界中に多くの人間が必要となり、その人間に対して絶大な信用が必要となり、今SEOスパムを排除することができたとしても、将来的拡大していくと予想できるウェブサイトを評価する上で危険とコストだけが増大することになるからです。人間の品質管理が行われていたとしても、あくまで新しいアルゴリズムが適切であったか、そうでなかったかの判断に使われる程度で、実際の検索アルゴリズムには導入されていることはないと予想しております。

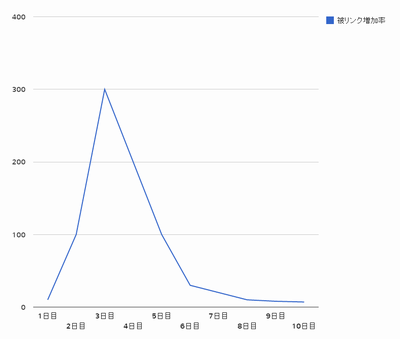

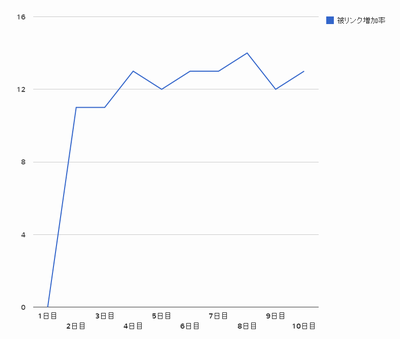

では、何を基準として低品質だというのでしょうか。被リンクに関する情報を基準としていると判断するのが一番妥当な線ではないでしょうか。もちろんリンクといってもスパムフィルタはあると思いますので、ナチュラルなリンクで、どのようなリンクが、どのようなタイミングで、どのぐらい継続して得られているか。こういったことを指標とすれば、ロボットにも低品質かそうでないかを判断することができそうです。

ここで疑問があります。冒頭の文章です。『サイト内に低品質なページが存在する場合、ランキングに影響を与えることがあります』低品質なページを、被リンクが得られないページと仮定した時に、問い合わせページや、会社概要ページは、低品質となるのかどうかという点です。もちろん、/contact、/company のようなURLには、通常被リンクが得られないことは予想できます。ですが、1.html、2.htmlのような構造をしていて、1.htmlが問い合わせフォームである可能性も十分に考えられます。

わかりやすい事例で説明しましたが、その他にもコンテンツとして必要であるけれども、リンクをもらうことができにくいページというものは存在すると思います。であるなら、それは不完全である可能性が高いということになります。必要であるけれどリンクをもらいにくいページを排除する必要が出てくることになります。ですので、考えられることとして、低品質なページは、多すぎなければ特に影響を受けることはない、ということであれば、納得できるのではないでしょうか。

サイト内に低品質なページがあれば影響を受ける。ここでもう一つの疑問が出てきます。それは、何を基準にサイトと判断しているのかという点です。ドメインということを基準としているのであれば、例えばライブドアブログの場合、blog.livedoor.jp/exampleというURLとblog.livedoor.jp/example2というURLの運営者は同じになってしまいます。サブドメイン形式であれば、また異なる結果となる可能性がありますが、このようにフォルダ区切りで運営者が異なるケースも存在します。

サイトのトップページというのは、URLで判断することはできません。先ほどのレンタルブログのケースでなくとも、/topというページがトップページとなっているサイトも存在します。YSTの場合、サイトを判断してサイト自体に評価を与えるという印象がありましたが、Googleはサイトという一括りですべてを考えているのではなくて、個々のウェブページに対して、評価を与えています。ですので、低品質なウェブページに対してリンクを張る行為が、サイト内外含めて、悪い影響を及ぼす可能性があると判断できるのではないでしょうか。

ライブドアブログの一部の運営者がスパムを行ってペナルティを受けた場合、それはすべての運営者に影響を及ぼすでしょうか。答えは受けないです。であるならば、本サイトとサブサイトを同一ドメインで独立したサイトとして発信するとします。運営者が同一であるかという判断はできない可能性があります。サブサイトで新しいコンテンツを追加し、もし、被リンクを多く獲得できたなら、本サイトと合体させ、被リンクを獲得することができなければ、本サイトと合体しないというような運営方法をすれば、質の高いコンテンツのみを集めることができるということになり、サイトの質は高くなる一方であると言えます。そんなことをしなくても、被リンクを獲得できないコンテンツは修正して充実させればよいということですが、スパム的な利用方法も考えられるということを意味しています。

そしてGoogleが開始したこと、それはウェブサイトの構造化です。サイト作成者やサイトコンテンツの情報を詳しくマークアップしてもらおうという動きです。もし、これがウェブマスターの間で大きく普及することができれば、サイトという括りを明確にすることができます。サブドメインでもフォルダ区切りであっても、異なる運営者か同一の運営者かどうかを知ることができます。重複コンテンツの問題も少なくなる可能性があります。さらに評価すべきコンテンツはどの部分であるのかを明確にすることができるかもしれません。今後の内部対策において、重要な位置を占めることになる可能性があります。

パンダアップデートの話題とは大きく反れてしまいましたが、何を言いたかったかというと、パンダアップデートによってSEOスパムの入口を塞ぎ、サイト構造化によって、SEOスパムの出口を塞いだ印象を受けました。