ドメインが強いから順位が上がる、ということを聞くことがありますが、これは正しい回答ではありません。間接的にはそういうこともありますが、後ほど説明します。例えば、yahoo.co.jpやgoogle.co.jpのウェブページは、検索結果で頻繁に登場するでしょうか。特にYahoo!は膨大なサイトコンテンツを保有していますが、検索結果であまり見ることはありません。ドメインやサイト単位で評価を与えているとするならば、Yahoo!のような有名サイトは検索結果を占領しているはずです。

一方でwikipediaのように様々なページで上位表示を達成しているサイトがあります。これは、ドメインの力が強いことが原因なのでしょうか。ヤフーとの大きな違いは質の高い(リンクを受けやすい)コンテンツのみで構成されているという点です。なぜ質の高いコンテンツのみで構成していれば上位表示ができるのかということですが、ウェブサイトの構造から説明する必要があります。

ヤフーのサイトは階層構造です。トップページからカテゴリがあり、3層目、4層目というように大きなピラミッドのような構造をしています。階層構造のメリットは、トップページに近いほど内部リンクが集まり、上位表示しやすい構造となっています。デメリットとしては、優先すべきコンテンツと、すべきでないコンテンツの分類が難しく、本来検索エンジンで上位化すべきコンテンツが、下層に埋もれてしまい、うまく内部リンクを渡せない状況になってしまうということです。最新情報のみトップに表示させることで、リンクを集中させることもありますが、継続的なものではありません。

wikipediaは網目構造です。一応カテゴリがあり、階層になっている箇所もありますが、基本的には網目状にリンクが張り巡らされ、内部リンクが均等に行き渡るような構造になっています。網目構造のメリットは、それぞれのページに対して均一な評価を与えることができるということです。wikipediaのような辞典のサイトはすべてのコンテンツが質の高いコンテンツとなる為、このような網目構造が非常に効果的ということになります。質の低いコンテンツが発生してしまうようなサイトの場合では、余計なページにまで内部リンクを集中させてしまいます。

内部リンクと外部リンクは、まったく別のものだとされる傾向にありますが、大きな違いはありません。対象のウェブページに張られたリンクを評価の対象としています。ですので、wikipediaのように、常に近くの内部ページが質の高いものであれば、ウェブページの評価は高いものとなります。ヤフーの場合で説明すると、ページが多くなった場合にはどんどん下層ページに追いやられます。下層ページに追いやられると、内部リンクをもらう為のページも下層ページですので、質の高いページからの内部リンクをもらうことができなくなってしまいます。補足ですが、今回の階層というのはリンクのことですので、URLの階層とは関係ありません。

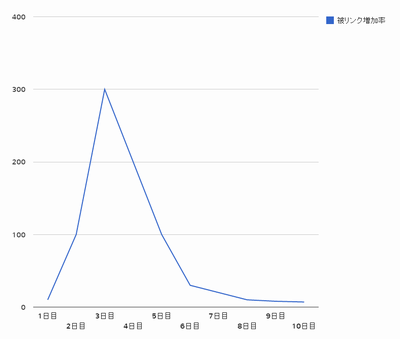

Yahoo!とwikipedia、いずれもドメインの強さというものがあれば申し分ないものだと思います。ですが、このようにコンテンツと構造の違いで大きな差が生まれています。ドメインの強さというものは特に気にする必要はありません。重要なのはリンクの流れです。内部リンク、外部リンク、それをどのウェブページに渡すのかという部分です。強いドメインであれば、新しい記事を公開した時にすぐ上位化されるという意見もあるかもしれません。ですが、それはただ、そのウェブページが質の高い内部リンクを一気に受けるからです。まったくリンクを張らない形でhtmlを作成して公開しても同じ状況になることはありません。もしドメインの強さというものが存在していたとしても、ほんのわずかなものでしかないということです。gov、edu、infoドメインでも評価が違うと言われることがありますが、同じような理由によって、同意見です。